Случалось ли вам встречать на улице человека, который один в один был бы похож на вас? Одежда, лицо, походка, манера общения, повадки полностью идентичны вашим. Как будто вас отсканировали и распечатали на принтере. Звучит немного жутковато, не так ли? А теперь представьте, что вы увидели видео, в котором такой человек что-то рассказывает о себе. В лучшем случае вы постараетесь вспомнить, когда гуляли так, что ничего не помнили, но могли наговорить такое на камеру. Пока все это звучит как простые рассуждения, но технологии уже вплотную приблизились к тому, чтобы создавать таких людей. Они уже есть, но скоро их станет намного больше.

Неважно, как мы представим лицо нейросетей. Опасности в них точно будут.

Содержание

- 1 Откуда берется фейк?

- 2 Что такое Deep Learning?

- 3 Что такое Deepfake? Когда появился Deepfake?

- 4 Опасность Deepfake. Как изменить лицо на видео?

- 5 Как выявить Deepfake?

- 6 Сценарий мрачного будущего

Откуда берется фейк?

Сейчас уже слишком много всего, что принято называть фейками. Они есть везде. Их можно найти в фотографиях, в новостях, в производстве товаров и в информационных услугах. Проще сказать где нет явлений, сопровождаемых этим словом. Пока с ними можно бороться. Можно изучить происхождение фотографии, проверить отличительные черты фирменного товара от подделки, а новости перепроверить. Хотя, новости являются отдельной темой.

В наше время потребитель контента не хочет ждать и требует от его создателя моментального производства, иногда ему даже плевать на качество, главное, чтобы быстро. Отсюда и рождаются ситуации, когда кто-то что-то сказал, а остальные, не проверив, растащили это по своим сайтам и газетам. В некоторых случаях требуется много времени на раскрутку этого клубка обратно и доказательство того, что это все было неправдой.

Объяснять, для чего это все делается, смысла нет. С одной стороны стоят те, кто просто хочет посмеяться над ситуацией, с другой — те, кто действительно не знали, что они неправы. Отдельное место, примерно посередине, занимают те, кому это банально выгодно. Это могут быть интересы влияния на разном уровне, включая политический. Иногда это бывает целью получения прибыли. Например, сеяние паники на фондовом рынке и проведение выгодных операций с ценными бумагами. Но зачастую это бывает связано с неприязнью к человеку (компании, продукту и т.д) с целью принизить его. Простым примером является “опускание” в рейтингах неугодного кому-то фильма или заведения. Конечно, для этого нужна армия тех, кто пойдет и поставит дизлайк (иногда даже ботов), но это уже отдельная история.

Что такое Deep Learning?

В последнее время этот термин звучит все чаще. Иногда он даже не имеет отношения к делу и его путают с чем-то другим. Так программный продукт выглядит более эффектно.

Глубокое обучение — (глубинное обучение; англ. Deep learning) — совокупность методов машинного обучения (с учителем, с частичным привлечением учителя, без учителя, с подкреплением), основанных на обучении представлениям, а не специализированным алгоритмам под конкретные задачи.

Не стоит думать, что понятие и основные принципы машинного обучения появились только несколько лет назад. На самом деле, им уже столько лет, что многие из нас тогда даже не родились. Основные принципы работы систем глубокого обучения и математические модели для их работы были известны еще в 80-е годы прошлого века.

В то время они не имели такого смысла из-за отсутствия одного важного компонента. Им являлась высокая вычислительная мощность. Только в середине двухтысячных появились системы, которые могут помочь работать в этом направлении и позволяют просчитывать всю необходимую информацию. Теперь машины развились еще сильнее и некоторые системы машинного зрения, голосового восприятия и некоторые другие работают настолько эффективно, что даже порой превосходят возможности человека. Хотя, на ответственные направления их пока не “сажают”, делая их дополнением возможностей человека с сохранением контроля над ними.

Мы их учим, но как они будут пользоваться своими знаниями и возможностями?

Что такое Deepfake? Когда появился Deepfake?

Несложно догадаться, что Deepfake это небольшая игра слов, связанная с Deep Learning и теми самыми фейками, о которых я рассказывал выше. То есть, Deepfake должен вывести подделку на новый уровень и разгрузить человека в этом нелегком деле, позволив создавать поддельный контент, не тратя на это силы.

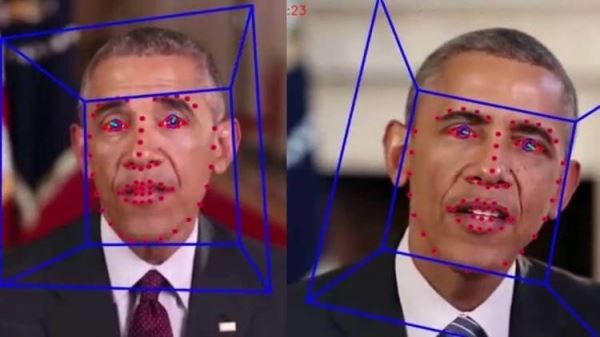

В первую очередь, такие подделки касаются видео. То есть, любой человек сможет сесть перед камерой, сказать что-то, а его лицо будет заменено на другого человека. Выглядит жутковато, ведь, по сути, надо будет просто уловить основные движения человека и отличить подделку будет просто невозможно. Давайте разберемся, с чего это все началось.

Первая генеративно-состязательная нейросеть была создана студентом Стэнфордского университета. Произошло это в 2014 году, а звали студента Ян Гудфеллоу. По сути, он столкнул между собой две нейросети, одна из которых занималась генерацией лиц людей, а вторая анализировала их и говорила похоже или нет. Так они обучали друг друга и в один прекрасный день вторая нейросеть начала путаться и принимать сгенерированные изображения за реальные. Именно такая постоянно усложняющаяся система и рождает Deepfake.

Сейчас одним из главных популяризаторов идеи Deepfake является Хао Ли (Hao Li). Он занимается не только этим, но и многим другим. За это он был не раз удостоен различных наград, в том числе, и негласных. Кстати, он один из тех, кому стоит сказать спасибо за появление в iPhone X анимодзи. Если интересно, на его сайте можно ознакомиться с ним более подробно. Сегодня не он является главной темой обсуждения.

Вспомнили мы о нем только из-за того, что на всемирном экономическом форуме в Давосе он показал свое приложение, которое позволит заменить лицо человека, сидящего перед камерой, на любое другое лицо. В частности, он показывал, как работает система на примере лиц Леонардо Дикаприо, Уилла Смита и других известных людей.

Выглядит это немного жутковато. С одной стороны, можно только восхититься современными технологиями, которые позволяют сканировать лицо, на ходу менять его на другое и выдавать новую картинку. На все это тратятся доли секунды и система даже не тормозит. То есть, это позволяет не просто обработать готовое видео и заменить лицо, но и участвовать такому персонажу в каком-нибудь живом общении по видеосвязи.

Опасность Deepfake. Как изменить лицо на видео?

Можно сколько угодно говорить о том, что такая технология нужна, это очень круто и не надо наговаривать. Можно даже дойти до крайности и начать говорить о том, что это позиция лютого олдфага, который просто боится всего нового, но тут действительно опасностей больше, чем пользы.

С такой технологией, особенно, если она будет с открытым кодом, любой желающий сможет сеcть и записать любое видео. Полбеды, если оно просто будет порочащим чью-то честь и достоинство, гораздо хуже, если это будет заявление, сделанное от имени важного человека. Например, записав ролик длиной всего 30-40 секунд от имени Тима Кука, можно обрушить чуть ли не всю IT-сферу США во главе с Apple. Фондовый рынок получит такой сильный удар, что это посеет панику среди инвесторов. В итоге тысячи людей потеряют в сумме миллиарды долларов.

Хороший вопрос: Может ли машинное обучение положить конец «понятной» науке?

Тот, кто не любит такой способ заработка, скажет, что так им и надо, пусть идут на завод. Но при самом печальном сценарии и завода не будет после такого. Кроме того, банально мы получаем человека, который обманом наварится на колебаниях стоимости ценных бумаг. Достаточно просто вовремя их купить и продать.

Ситуация может быть и хуже, если “шутник” выскажется от лица лидера крупного государства. Конечно, потом все вскроется, но за это время можно натворить немало неприятных дел. На фоне этого, просто подставить лицо знаменитости вместо актера в фильме для взрослых будет невинной шалостью.

С такими технологиями главное сканировать, а дальше дело техники. В прямом смысле слова.

Можно представить и обратную ситуацию, когда реальный человек что-то скажет, а потом будет всех уверять, что его подставили. Как быть в этой ситуации тоже не очень понятно. Это внесет такую смуту в новостные ленты, что перепроверить это в другом источнике просто не получится. В итоге станет вообще непонятно, что в этом мире правда, а что ложь. Вырисовывается картинка из фильмов о мрачном будущем, вроде Суррогатов или Терминатора, где Т-1000 представлялся другими людьми и, в том числе, звонил Джону Конору от имени его приемной матери.

Сейчас я даже не говорю о еще одном злоупотреблении, которое позволит собирать ложные улики. На фоне этого вся забавность игрушки становится слишком сомнительной.

Как выявить Deepfake?

Проблема даже не в том, что такие системы надо запретить, а в том, что это уже невозможно. Они уже есть и развитие технологий, в том числе, и считывания лиц привело к их появлению и распространению открытого кода. Даже если представить, что система в нынешнем виде перестанет существовать, надо понимать, что ее создадут заново. Просто еще раз научат нейросети работать между собой и все.

Когда нейросети выйдут из под контроля, вы сможете узнать об этом из нашего новостного канала в Telegram. Присоединяйтесь, пока не поздно.

Пока не все так страшно, и определить подделку можно буквально невооруженным глазом. Картинка похожа, но она достаточно грубая. Кроме этого, она иногда имеет некоторые проблемы с совмещением, особенно по границам лица. Но ничего не стоит на месте и развить ее еще больше совсем не сложно. Тот же Хао Ли уверен, что на это потребуется не больше нескольких месяцев, а для создания “масок”, которые не отличит даже компьютер, надо еще несколько лет. После этого пути назад уже не будет.

С одной стороны, от этого сможет защитить алгоритм, который уже создают YouTube и Facebook. Кстати, последние даже открыли конкурс на разработку технологии распознавания — Deepfake Detection Challenge («Задача по выявлению дипфейков»). Призовой фонд этого конкурса составляет 10 миллионов долларов. Конкурс уже идет и завершится в марте 2020 года. Еще можно успеть поучаствовать.

Заменить лицо на видео перестало быть проблемой.

Возможно, такая щедрость обусловлена фейковым видео с самим Марком Цукербергом. Если эти две вещи связаны, появление такого конкурса неудивительно.

Если замененное лицо будет полностью соответствовать оригиналу, противосила в лице специальной нейросети будет бессильна. В этом случае ей придется ловить минимальные отличия в мимике, движениях и манере говорить. В случае с известными людьми такая проблема будет решена на уровне видеосервиса, так как тот же YouTube знает, как двигается условный Дональд Трамп. Когда дело дойдет до менее известного человека, это будет сложнее. Хотя, это тоже можно будет доказать, посадив его перед камерой и ведя непринужденную беседу, пока нейросеть анализирует его движения. Получится что-то вроде изучения отпечатка пальца, но, как видим, это опять приведет к излишним сложностям.

Если вшить системы определения подлинности видео в камеры, их тоже можно будет обойти. Можно сделать так, чтобы камера маркировала снятое видео и было понятно, что оно не снято через отдельное приложение или не обработано в специальной программе. Но как в этом случае быть с видео, которые просто были обработаны. Например, смонтированное интервью. На выходе мы получим видео, в котором уже не будет того исходного ключа.

Немного мемов в конце.

Сценарий мрачного будущего

Можно ли сказать, что мы сейчас набросали один из сценариев мрачного будущего? В целом да. Если технологии, которые были созданы для достижения хороших целей, выйдут из под контроля, с ними можно хлебнуть горя. Собственно, вариантов таких опасных технологий много, но бОльшая часть из них находится под защитой. Например, ядерный синтез. Тут мы имеем дело с кодом, который может получить каждый.

Напишите в комментариях, какой вы видите защиту от подделок, если учесть, что система наложения масок смогла сделать маски полностью идентичными оригинальным лицам. А из-за того, что они на видео, к ним нельзя даже применить распознавание глубины и объема. Кроме этого, допустим, что любой код и зашитый в изображение ключ можно взломать. Как говорится, было бы ради чего. Теперь можно обсуждать, все вводные есть.

Источник: hi-news.ru